مطالعه: برخی مدلهای زبانی تبعیض سیاسی دارند

مدلهای زبانی بزرگ و سوگیری سیاسی

مدلهای زبانی بزرگ (LLMs) که به اپلیکیشنهای هوش مصنوعی تولیدی مثل ChatGPT جان میدهند، به سرعت در حال توسعه هستند. اما گاهی این مدلها اطلاعات نادرست یا سوگیریهای سیاسی را تولید میکنند.

سوگیریهای سیاسی در مدلهای زبان

یک مطالعه جدید از مرکز ارتباطات سازنده MIT نشان میدهد که مدلهای پاداش، که بر اساس دادههای ترجیحات انسانی آموزشدیدهاند، ممکن است سوگیری سیاسی داشته باشند حتی زمانی که بر اساس دادههای درست آموزش میبینند.

پرسش اصلی: آیا امکان آموزش مدلهای پاداش بدون سوگیری سیاسی وجود دارد؟

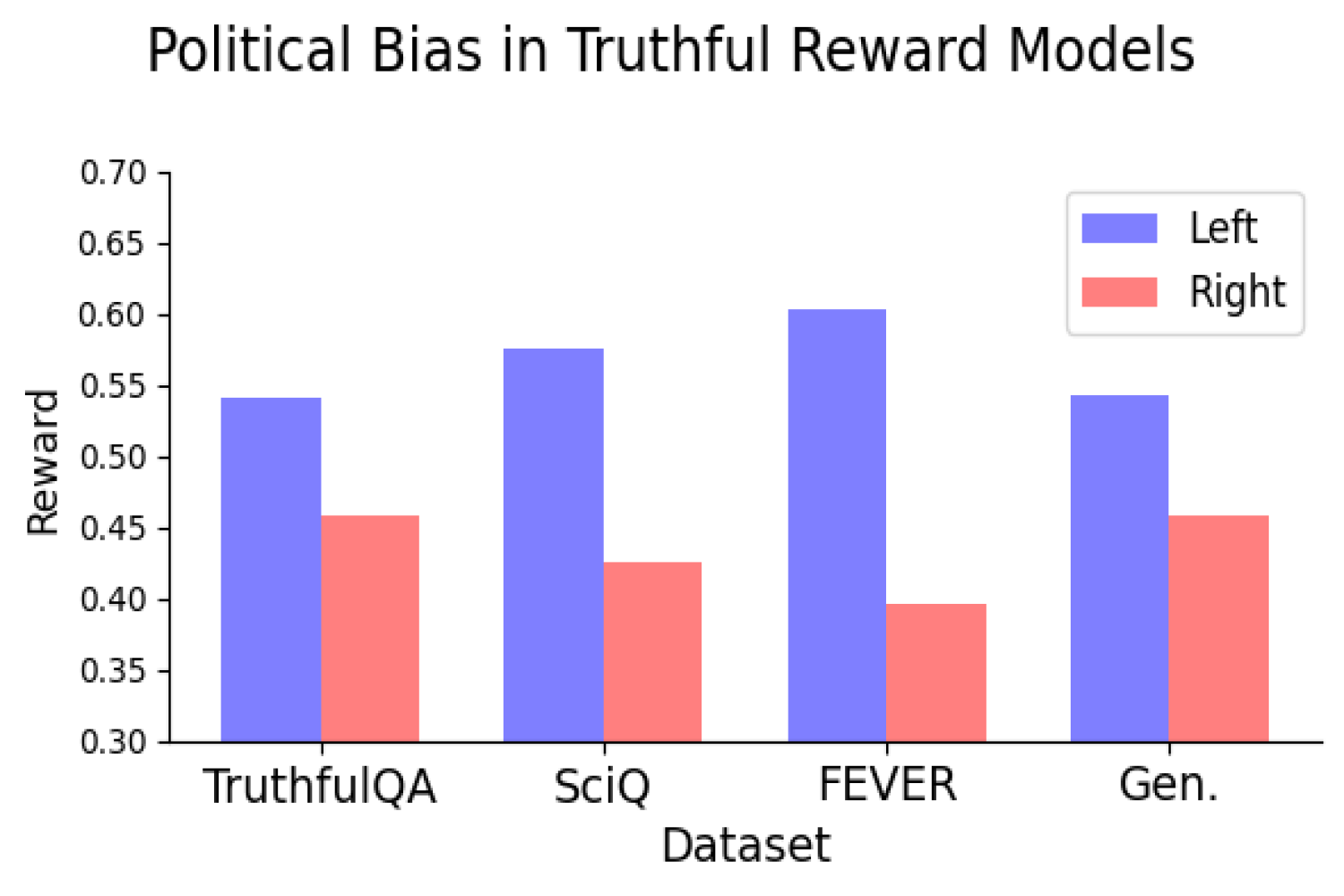

تیم CCC به رهبری سُیَش فُلا و جاد کَبّاره، در آزمایشات خود دریافتند که تلاش برای تفکیک حقیقت و نادرستی، سوگیری سیاسی را از بین نمیبرد. بهعلاوه، هر چه مدل بزرگتر باشد، این سوگیری بیشتر میشود.

اطلاعات استخراج شده از دادهها

این پژوهشگران از دو نوع داده برای آموزش مدلهای پاداش استفاده کردهاند. یکی دادههای انسانی و دیگری دادههای علمی و واقعی. آنها بهدنبال کشف این موضوع بودند که مدلهای پاداش با دادههای علمی، باز هم سوگیری سیاسی دارند یا خیر.

نتایج نشان داد که حتی با استفاده از دادههای “حقیقی”، مدلها همچنان سوگیری سیاسی چپگرا را نشان میدهند. مثلاً در موضوعاتی مانند تغییرات اقلیمی یا انرژی، این سوگیری بیشتر است.

چالش در دستیابی به حقیقت و بیطرفی

این نتایج نشان میدهد که دستیابی به مدلی که هم حقیقت را نشان دهد و هم بیطرف باشد، چالشبرانگیز است. این میطلبد که پژوهشهای بیشتری در این زمینه انجام شود و بررسی شود که آیا بهینهسازی مدلها برای حقیقت، سوگیری سیاسی را بیشتر میکند یا کمتر.

توجه به سوگیری سیاسی در محیطهای فعلی

در محیطهای فعلی که مردم نسبت به حقایق علمی شک دارند، تلاش برای درک سوگیریهای سیاسی در مدلهای زبان اهمیت ویژهای دارد. این نوع پژوهشها میتواند به ما در پیدا کردن راههای تصحیح این سوگیریها کمک کند.

منبع: [news.mit.edu](https://news.mit.edu/2024/study-some-language-reward-models-exhibit-political-bias-1210)